Erst letztes Jahr hat Google DeepMinds AlphaGo die Welt der Künstlichen Intelligenz (KI) im Sturm erobert und gezeigt, dass ein Computerprogramm die besten menschlichen Go-Spieler der Welt schlagen kann.

Aber in einer Demonstration des fieberhaften Fortschritts in der modernen KI wurden diese Woche in Nature Details zu einem neuen Meilenstein veröffentlicht, den eine verbesserte Version namens AlphaGo Zero erreicht hat.

Mit weniger Rechenleistung und nur drei Tagen Trainingszeit schlug AlphaGo Zero das ursprüngliche AlphaGo in einem 100-Spiele-Match mit 100 zu 0. Es hat sich nicht einmal gelohnt, dass Menschen aufgetaucht sind.

Go spielen lernen

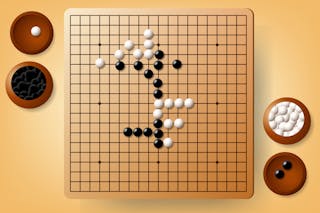

Go ist ein Strategiespiel zwischen zwei Spielern, die abwechselnd „Steine“ auf ein 19×19 großes Brett legen. Das Ziel ist es, eine größere Fläche des Brettes zu umschließen als der Gegner.

Go hat sich für Computer als viel schwieriger zu meistern erwiesen als Schach. Es gibt viel mehr mögliche Züge in jeder Stellung als beim Schach und viel mehr mögliche Partien.

Das ursprüngliche AlphaGo lernte zunächst durch das Studium von 30 Millionen Zügen von menschlichen Experten. Es verbesserte sich dann über die menschliche Expertise hinaus, indem es viele Partien gegen sich selbst spielte, was mehrere Monate Computerzeit in Anspruch nahm.

Im Gegensatz dazu hat AlphaGo Zero nie Menschen spielen sehen. Stattdessen begann es damit, nur die Spielregeln zu kennen. Nach relativ bescheidenen fünf Millionen selbst gespielten Partien, für die es nur drei Tage auf einem kleineren Computer als das ursprüngliche AlphaGo benötigte, erlernte es dann die Super-AlphaGo-Leistung.

Faszinierenderweise ahmte sein Lernprozess einige der Phasen nach, die Menschen durchlaufen, wenn sie Go beherrschen. AlphaGo Zero lernte schnell, naiv kurzfristige Ziele abzulehnen und entwickelte mehr strategisches Denken und generierte viele der Muster von Zügen, die oft von menschlichen Experten auf höchster Ebene verwendet werden.

Aber bemerkenswerterweise begann es dann, einige dieser Muster zugunsten neuer Strategien zu verwerfen, die nie zuvor im menschlichen Spiel gesehen wurden.

Über das menschliche Spiel hinaus

AlphaGo Zero erreichte dieses Kunststück, indem es das Problem anders als das ursprüngliche AlphaGo anging. Beide Versionen verwenden eine Kombination aus zwei der leistungsfähigsten Algorithmen, die derzeit die KI antreiben: Deep Learning und Reinforcement Learning.

Um ein Spiel wie Go zu spielen, gibt es zwei grundlegende Dinge, die das Programm lernen muss. Das erste ist eine Strategie: die Wahrscheinlichkeit, jeden der möglichen Züge in einer gegebenen Position auszuführen. Das zweite ist ein Wert: die Wahrscheinlichkeit, aus einer gegebenen Position zu gewinnen.

Im reinen Reinforcement-Learning-Ansatz von AlphaGo Zero war die einzige Information, die zum Erlernen von Richtlinien und Werten zur Verfügung stand, die Vorhersage, wer letztendlich gewinnen könnte. Um diese Vorhersage zu treffen, benutzte es seine aktuelle Politik und Werte, aber zu Beginn waren diese zufällig.

Dies ist eindeutig ein anspruchsvollerer Ansatz als das ursprüngliche AlphaGo, das menschliche Expertenzüge benutzte, um einen Lernvorsprung zu bekommen. Aber die frühere Version lernte Richtlinien und Werte mit separaten neuronalen Netzen.

Der algorithmische Durchbruch in AlphaGo Zero bestand darin, herauszufinden, wie diese in einem einzigen Netzwerk kombiniert werden können. Dies ermöglichte es, den Prozess des Trainings durch Selbstspiel stark zu vereinfachen, und machte es möglich, von einer weißen Weste zu beginnen, anstatt zuerst zu lernen, was erfahrene Menschen tun würden.

Eine Elo-Bewertung ist ein weit verbreitetes Maß für die Leistung von Spielern in Spielen wie Go und Schach. Der bisher beste menschliche Spieler, Ke Jie, hat derzeit eine Elo-Zahl von etwa 3.700.

AlphaGo Zero trainierte drei Tage lang und erreichte eine Elo-Zahl von mehr als 4.000, während eine erweiterte Version des gleichen Algorithmus 40 Tage lang trainierte und fast 5.200 erreichte.

Das ist ein erstaunlich großer Schritt nach oben gegenüber dem besten Menschen – weit größer als der derzeitige Abstand zwischen dem besten menschlichen Schachspieler Magnus Carlsen (ca. 2.800) und dem Schachprogramm (ca. 3.400).

Die nächste Herausforderung

AlphaGo Zero ist ein wichtiger Schritt vorwärts für die KI, weil es die Machbarkeit von reinem Reinforcement Learning demonstriert, das nicht von menschlicher Anleitung beeinträchtigt wird. Damit entfällt die Notwendigkeit von viel menschlichem Expertenwissen, das in manchen Bereichen nur schwer zu bekommen ist, um loszulegen.

Es bedeutet auch, dass der Algorithmus frei ist, völlig neue Ansätze zu entwickeln, die viel schwieriger zu finden gewesen wären, wenn er anfangs gezwungen gewesen wäre, „in der menschlichen Box zu denken“. Bemerkenswerterweise erweist sich diese Strategie auch als rechnerisch effizienter.

Aber Go ist ein eng begrenztes Spiel mit perfekter Information, ohne die Unordnung der meisten Probleme in der realen Welt. Das Training von AlphaGo Zero erforderte die genaue Simulation von Millionen von Spielen, die den Regeln von Go folgen.

Für viele praktische Probleme sind solche Simulationen rechnerisch nicht durchführbar, oder die Regeln selbst sind weniger klar.

Es gibt noch viele weitere Probleme, die gelöst werden müssen, um eine Allzweck-KI zu schaffen, eine, die eine breite Palette praktischer Probleme ohne domänenspezifisches menschliches Eingreifen bewältigen kann.

Aber auch wenn der Mensch den Kampf mit den Go-Algorithmen nun umfassend verloren hat, ist KI (im Gegensatz zu Go) glücklicherweise kein Nullsummenspiel. Viele der Partien von AlphaGo Zero sind inzwischen veröffentlicht worden und bieten menschlichen Go-Spielern ein Leben lang inspirierende Studien.

Wichtiger noch: AlphaGo Zero stellt einen Schritt in Richtung einer Welt dar, in der Menschen leistungsstarke KI nutzen können, um (für Menschen) unvorstellbar kreative Lösungen für schwierige Probleme zu finden. In der Welt der KI gab es noch nie einen besseren Zeitpunkt, um Go zu spielen.