Het indexeringsproces van Google is gecompliceerd, met veel fasen die elkaar beïnvloeden.

Om ervoor te zorgen dat ze uw website snel indexeren, moet u ervoor zorgen dat er geen wegversperringen zijn die Google verhinderen om in de eerste plaats te indexeren.

Ten tweede, doe wat u kunt om Google te laten weten dat u verse inhoud hebt en dat u wilt dat uw website wordt geïndexeerd. Houd in gedachten dat de kwaliteit van uw content en het gebrek aan interne links een deal-breaker kan zijn in het indexeringsproces.

Ten slotte, vergroot de populariteit van uw website door het bouwen van externe links naar uw website en door mensen over uw content te laten praten op sociale media.

Als uw content niet op Google staat, bestaat het dan wel?

Om uw website zichtbaar te laten zijn op de dominante zoekmachine, moet deze eerst worden geïndexeerd. In dit artikel laten we u zien hoe u Google uw site snel en efficiënt kunt laten indexeren en welke wegversperringen u daarbij moet vermijden.

Google’s indexeringsproces in een notendop

Voordat we ingaan op hoe u uw website kunt indexeren, geven we eerst een vereenvoudigde uitleg over hoe Google’s indexeringsproces werkt.

Google’s index kan worden vergeleken met een enorme bibliotheek – een die groter is dan alle bibliotheken in de wereld bij elkaar!

De index bevat miljarden en miljarden pagina’s, waaruit Google de meest relevante selecteert wanneer gebruikers zoekopdrachten geven.

Met zoveel inhoud die voortdurend verandert, moet Google voortdurend zoeken naar nieuwe inhoud, inhoud die is verwijderd, en inhoud die is bijgewerkt – allemaal om zijn index up-to-date te houden.

Om Google uw site te laten ranken, moet deze eerst deze drie fasen doorlopen:

-

Discovery: Door XML-sitemaps te verwerken en links te volgen op andere pagina’s die Google al kent, ontdekt de zoekmachine nieuwe en bijgewerkte pagina’s en zet deze in de wachtrij voor crawling.

Crawling: Google gaat vervolgens verder met het crawlen van elke ontdekte pagina en geeft alle informatie die het vindt door aan de indexeringsprocessen.

Indexeren: De indexeringsprocessen verwerken onder andere inhoudsanalyse, renderen pagina’s en bepalen of ze al dan niet worden geïndexeerd.

Google’s indexeringsproces is zeer complex, met veel onderlinge afhankelijkheden tussen de stappen die in het proces zijn opgenomen. Als een deel van het proces fout gaat, heeft dat ook gevolgen voor andere fasen.

Op 10 augustus 2020 bijvoorbeeld, merkte de SEO-gemeenschap een vlaag van veranderingen in de rangschikking van de zoekresultaten op. Velen beweerden dat dit betekende dat Google een belangrijke update aan het uitrollen was. Maar de volgende dag kondigde Google aan dat het in feite werd veroorzaakt door een bug in hun indexeringssysteem dat van invloed was op de rankings:

Om wat licht te werpen op hoe het indexeringsproces gecompliceerd en met elkaar verweven is, legde Garry Illyes de Caffeine-workflow uit in een Twitter thread:

Deze tweet suggereert dat een bug in de indexeringsfase een groot effect kan hebben op het proces dat erop volgt – in dit geval het in de war schoppen van het rankingsysteem.

Naast deze gebeurtenis is het belangrijk om op te merken dat Google in mei 2020 een brede kernupdate onderging die van invloed was op het indexeringsproces. Sindsdien is Google trager met het indexeren van nieuwe inhoud en is het kieskeuriger over de inhoud die het besluit te indexeren. Het lijkt erop dat het kwaliteitsfilterproces een stuk strenger is geworden dan voorheen.

Hoe controleer je of Google je website heeft geïndexeerd?

Er zijn verschillende snelle manieren om te controleren of Google uw website heeft geïndexeerd, of dat ze nog vastzitten in de voorgaande fasen ontdekken en crawlen.

Feedback van Google Search Console

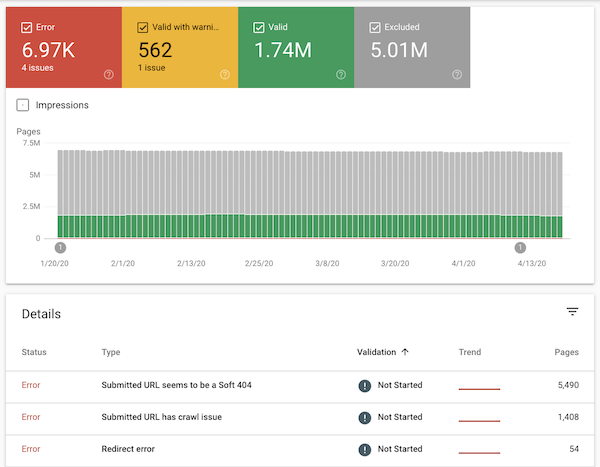

Gebruik het Index Coverage Report van Google Search Console om een snel overzicht te krijgen van de indexeringsstatus van uw website. Dit rapport geeft feedback over de meer technische details van het crawl- en indexeringsproces van uw site.

Het rapport retourneert vier soorten statussen:

- Geldig: deze pagina’s zijn met succes geïndexeerd.

- Geldig met waarschuwingen: deze pagina’s werden geïndexeerd, maar er zijn enkele problemen die u misschien wilt controleren.

- Uitgesloten: deze pagina’s werden niet geïndexeerd, omdat Google duidelijke signalen oppikte dat ze ze niet moesten indexeren.

- Fout: Google kon deze pagina’s om de een of andere reden niet indexeren.

- Log in op Google Search Console.

- Kies een eigenschap.

- Klik op

CoverageonderIndexin de linker navigatie.

Hier ziet u een voorbeeld van hoe een Index Coverage rapport voor een grote website eruit ziet:

Met het Index Coverage-rapport kunt u snel de algehele indexeringsstatus van uw site controleren, en ondertussen kunt u de URL Inspection-tool van Google Search Console gebruiken om in te zoomen op afzonderlijke pagina’s.

- Log in op Google Search Console.

- Kies een eigenschap.

- Voeg een URL in van de website die u wilt controleren.

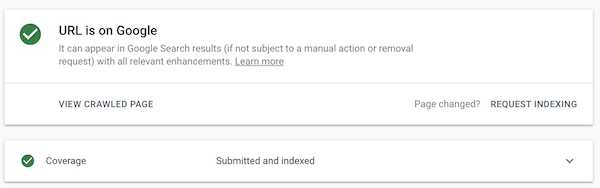

Daarna ziet u iets als dit:

Als de URL-inspectietool aangeeft dat de URL nog niet is geïndexeerd, kunt u dezelfde tool gebruiken om indexering aan te vragen.

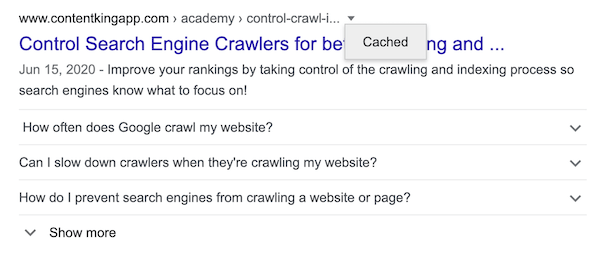

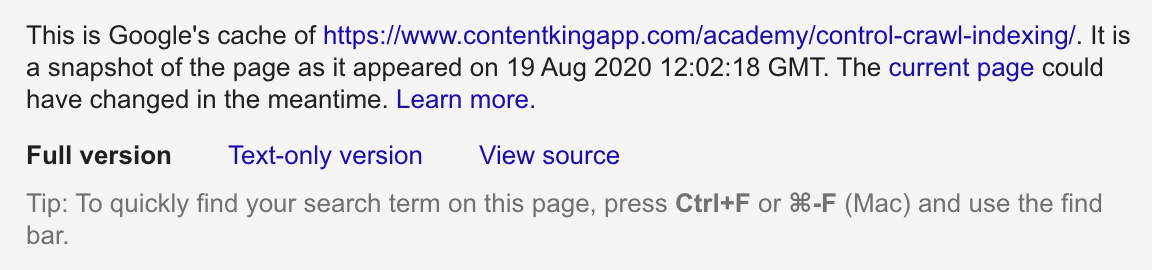

Controleer de cache van de URL

Controleer of uw URL een cache-versie heeft in Google, door cache:https://example.com in te typen in Google of de adresbalk, of door te klikken op het kleine pijltje dat naar beneden wijst onder de URL op een SERP.

Als u een resultaat ziet, heeft Google uw URL geïndexeerd. Hier is een voorbeeld voor een van onze artikelen:

De datum in de schermafbeelding verwijst naar de laatste keer dat de website werd geïndexeerd. Houd er rekening mee dat het niets zegt over wanneer de website voor het laatst is gecrawld. De website kan later opnieuw zijn gecrawld zonder dat Google de updates heeft geïndexeerd, zoals Garry Illyes aangaf in deze tweet.

Ook het controleren van een URL’s cache is niet foolproof – je kunt een gecachete pagina zien, ook al is – in de tussentijd – de pagina uit Google’s index verwijderd.

Als het rankt, is het geïndexeerd

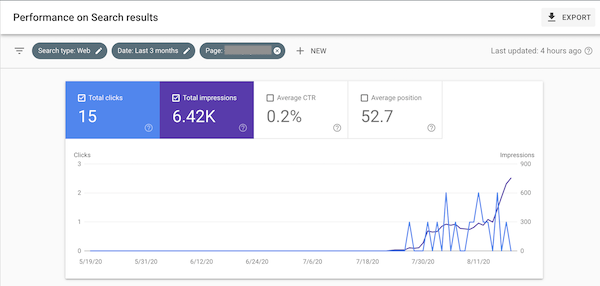

Een andere manier om te controleren of uw pagina’s zijn geïndexeerd, is te controleren of ze ranken met behulp van een rank tracker, of gewoon door de prestatiegegevens van Google Search Console te controleren om te zien of u klikken en vertoningen krijgt:

- Log in op Google Search Console.

- Kies een eigenschap.

- Klik op

Search resultsonderPerformanceaan de linkerkant. - Filter daar op de pagina die je zoekt door bovenin op het filter te klikken. Standaard opent deze met de instelling

URLs containing. Vul hier de URL(s) in die je zoekt.

Daarna ziet u iets als dit:

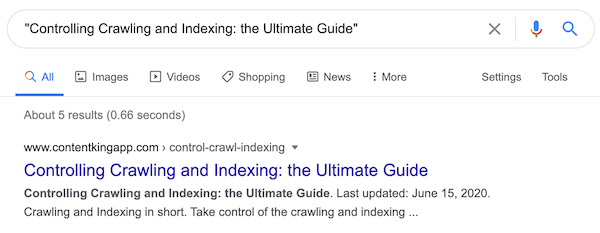

Zoeken naar de exacte paginatitel of URL

Als alternatief, om te zien of een pagina is geïndexeerd, kunt u naar de exacte paginatitel zoeken door deze tussen aanhalingstekens te zetten (”Your page’s title”), de zoekoperator intitle: met de titel van uw pagina gebruiken (intitle:"Your page's title") of gewoon de URL in Google invoeren.

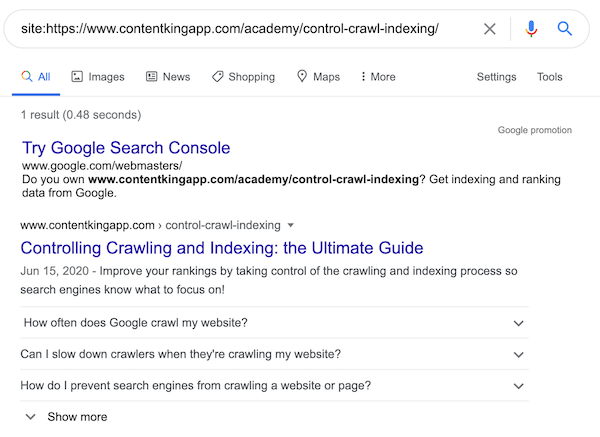

site: query’s

U kunt ook nagaan of uw pagina is geïndexeerd door de site: query voor de pagina te gebruiken. Hier is een voorbeeld: door site:https://www.contentkingapp.com/academy/control-crawl-indexing/ in te voeren, kunt u zien of die pagina is geïndexeerd.

Deze aanpak is echter niet altijd betrouwbaar!

We hebben gevallen gezien waarin pagina’s wel in de ranking staan, maar niet worden weergegeven bij site:-query’s. Vertrouw dus nooit alleen op deze controle.

Hoe Google uw website snel kan indexeren

Om uw website door Google te laten indexeren, moet u zich ontdoen van alle wegversperringen die Google zouden verhinderen om uw website in de eerste plaats te indexeren.

Ten tweede moet u het Google gemakkelijker maken om uw inhoud te ontdekken met een duwtje in de rug. Vergeet niet dat Google er altijd op uit is om hun gebruikers te voorzien van kwalitatief hoogwaardige content om hun zoekopdrachten adequaat te beantwoorden. Zorg ervoor dat je content hieraan voldoet.

Finitief, boost de populariteit van je content door backlinks te winnen en mensen over je content te laten praten op social media.

1. Voorkom dat robots directives de indexering beïnvloeden

Een veel voorkomende reden waarom Google uw content niet indexeert, is vanwege de robots noindex directive. Hoewel deze richtlijn u helpt problemen met dubbele inhoud te voorkomen, geeft het Google een sterk signaal om bepaalde pagina’s op uw website niet te indexeren. Meta robots directives kunnen worden geïmplementeerd via de HTML-bron en de HTTP-header.

In uw HTML-bron kan de meta robots tag er ongeveer zo uitzien:

<meta name="robots" content="noindex,follow" />.

Sluit deze alleen in op pagina’s die u beslist niet geïndexeerd wilt zien, en als een pagina die u wel wilt indexeren indexeringsproblemen heeft, controleer dan of de noindex-richtlijn niet is geïmplementeerd.

Word direct gewaarschuwd als belangrijke pagina’s worden geneindexeerd. Geen SEO-verrassingen meer!

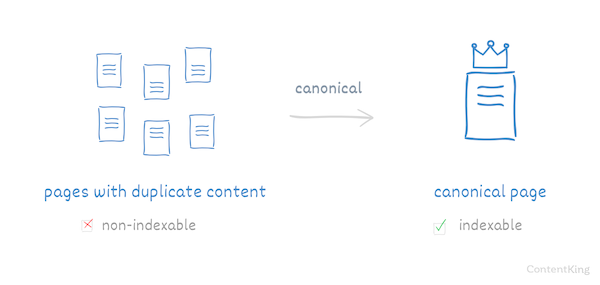

2. Stel canonical tags correct in

Hoewel canonical tags niet zo’n sterk signaal zijn als meta robots directive, kan het onjuiste gebruik ervan leiden tot indexeringsproblemen. Zorg ervoor dat de pagina’s die u geïndexeerd wilt hebben niet gecanoniseerd zijn.

Een van de dingen die ik heb gezien, is dat sites die zich zo druk maken over het canonicaliseren van hun pagina’s, uiteindelijk canonicaliseren naar pagina’s die ook zijn gemarkeerd met

noindex.Google heeft duidelijke, consistente signalen nodig, dus het canonicaliseren van je content naar een pagina die gemarkeerd is met

noindexkan de prestaties van de betreffende pagina’s in hun spoor stoppen.

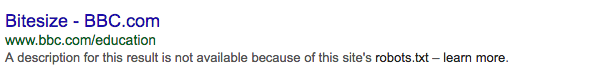

3. Verbied inhoud die u wel geïndexeerd wilt zien

Het robots.txt-bestand is een belangrijk hulpmiddel dat aan alle zoekmachines signalen afgeeft over de crawlbaarheid van uw URL’s. Het kan worden ingesteld om Google te laten weten dat het bepaalde delen van uw website moet negeren.

Zorg ervoor dat de URL’s die u geïndexeerd wilt hebben niet worden geweigerd in robots.txt. Een fout in uw robots.txt kan ertoe leiden dat nieuwe inhoud en updates van inhoud niet worden geïndexeerd. Wees u ervan bewust dat iedereen fouten kan maken in het robots.txt-bestand – zelfs grote bedrijven zoals Ryanair.

Om te controleren welke pagina’s worden geblokkeerd door robots.txt, controleert u het rapport “Geïndexeerd, maar geblokkeerd door robots.txt” in Google Search Console.

Het weigeren van een URL in robots.txt betekent niet noodzakelijkerwijs dat de site zal verdwijnen uit Google Search. De website kan wel in de SERP’s verschijnen, maar met een slechte snippet.

Het robots.txt-bestand is misschien eenvoudig in het gebruik, maar is ook behoorlijk krachtig als het erom gaat een grote puinhoop te veroorzaken. Ik heb veel gevallen gezien waarin websites “klaar voor gebruik” waren en live werden gezet met een

Disallow: /.Het resultaat is dat alle pagina’s worden geblokkeerd voor zoekmachines, en dat niemand de website kan vinden via Google Search. Ondertussen begint de klant zich af te vragen waarom Google niets indexeert. Eén regel code kan onopgemerkt passeren, en Google blokkeren om alle inhoud van uw website te vinden!

4. Voorkom crawler traps en optimaliseer crawl budget

Om ervoor te zorgen dat u het maximale uit het crawlen van uw website door Google haalt, vermijdt u het creëren van crawler traps. Crawler traps zijn structurele problemen binnen een website die ertoe leiden dat crawlers een vrijwel oneindig aantal irrelevante URL’s vinden, waarin de crawlers kunnen verdwalen.

U moet ervoor zorgen dat de technische basis van uw website op peil is, en dat u de juiste tools gebruikt die snel crawler traps kunnen detecteren waar Google mogelijk uw waardevolle crawlbudget aan verspilt.

De grootste oorzaak van crawler traps op websites komt tegenwoordig van gefacetteerde navigatie en filters voor prijzen of afmetingen (vooral als je er meerdere kunt selecteren). Als je deze URL’s niet verbergt voor Google, kun je gemakkelijk miljoenen extra URL’s creëren van slechts een paar pagina’s. Vergeet niet dat Google zowel gewone links als JavaScript links kan volgen en dat URL’s hoofdlettergevoelig zijn.

Mijn advies: zorg ervoor dat alle URL variaties die geblokkeerd moeten worden, ook echt geblokkeerd worden!

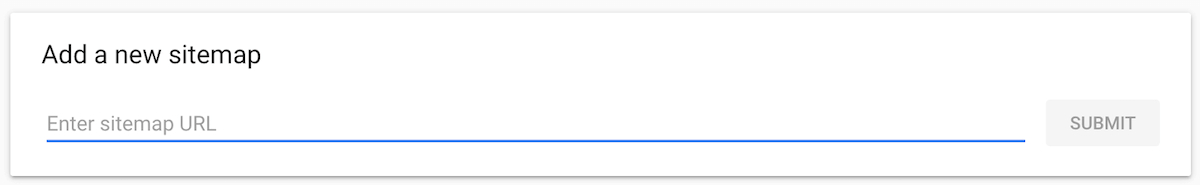

5. Geef Google indexeerbare content via een XML-sitemap

Als je er zeker van bent dat er aan jouw kant geen blokkade is, moet je het Google gemakkelijk maken om je URL’s te ontdekken en om de infrastructuur van je website in het algemeen te begrijpen. XML-sitemaps zijn een goede manier om dit te doen.

Alle nieuw gepubliceerde content of bijgewerkte content die geïndexeerd moet worden, moet automatisch aan uw XML-sitemap(pen) worden toegevoegd. Om uw content gemakkelijk vindbaar te maken voor Google, dient u uw XML-sitemap(s) in bij Google Search Console.

- Teken in op Google Search Console.

- Selecteer het object waarvoor u een sitemap wilt indienen.

- Klik op

SitemapsonderIndexaan de linkerkant. - Voeg de URL voor de XML-sitemap in.

Google zal vervolgens regelmatig uw ingediende XML-sitemap controleren op nieuwe inhoud om te ontdekken, te crawlen en -hopelijk- te indexeren.

Als je een grote website hebt, houd er dan rekening mee dat je XML-sitemaps moet beperken tot maximaal 50.000 URL’s. Het is beter om meer XML-sitemaps te genereren met elk minder URL’s dan om die limiet te overschrijden.

Oliver Mason heeft een XML sitemap strategie beschreven (opent in een nieuw tabblad) waarin hij het aantal URL’s beperkte tot 10.000 en ze chronologisch ordende – met sitemap1.xml die de oudste pagina’s bevat, en sitemap14.xml die de meest recente pagina’s bevat.

Dit leidde tot een betere indexering. Het lijkt erop dat het loont om Google kleinere hoeveelheden URL’s te geven en nieuwe inhoud te groeperen.

Mijn manier om iets snel geïndexeerd te krijgen is altijd om de site in Search Console te controleren en daar vervolgens de XML-sitemap in te dienen.

Zorg er altijd voor dat je XML-sitemap alle pagina’s bevat die je geïndexeerd wilt hebben, en zo is georganiseerd dat Google ze kan lezen – met sitemap-indexen indien nodig.

Voor mij is dit de beste manier geweest om bij Google aan te kloppen en ze te laten weten dat ze ASAP door de website kunnen gaan en alles wat er te vinden is kunnen crawlen/indexeren, en je kunt altijd terugkijken om te zien wanneer het is ingediend en voor het laatst door Google is gelezen.

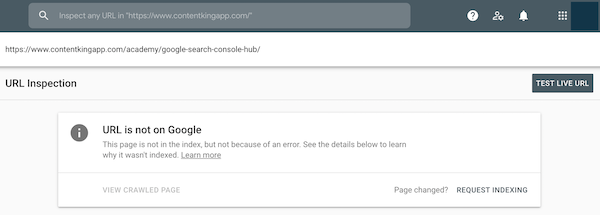

6. Dien uw URL’s handmatig in bij Google Search Console

Hoewel Google uw nieuwe of bijgewerkte pagina’s zelf zal ontdekken, crawlen en mogelijk indexeren, loont het toch de moeite om een duwtje in de rug te geven door URL’s in te dienen bij Google Search Console. Op deze manier kunt u ook het rankingproces versnellen.

U kunt uw URL’s indienen in de URL-inspector van GSC:

- Teken in op Google Search Console

- Selecteer een website waarvoor je een URL wilt indienen

- Voeg de URL in het bovenste deel van Google Search Console in

- Controleer of de URL indexeerbaar is door op de

TEST LIVE URLknop te klikken.

- Klik op de

REQUEST INDEXINGknop. - Doe hetzelfde voor pagina’s die linken naar de pagina die u door Google wilt laten indexeren.

Houd er rekening mee dat pagina’s geïndexeerd kunnen zijn en toch geen ranking hebben. Als u bijvoorbeeld indexering aanvraagt in Google Search Console (GSC), worden uw pagina’s snel geïndexeerd, maar ze zullen niet meteen ranken. Over het algemeen zal dit het hele proces echter versnellen.

7. Post indienen via Google Mijn Bedrijf

Het indienen van een post via Google Mijn Bedrijf geeft Google een extra zetje om URL’s die u daar hebt opgenomen te crawlen en te indexeren. We raden niet aan om dit zomaar voor elke post te doen, en houd er rekening mee dat deze post zal worden weergegeven in het kennispaneel van Google Mijn Bedrijf aan de rechterkant voor zoekopdrachten naar merken.

- Teken in op Google Mijn bedrijf (wordt geopend in een nieuw tabblad)

- Kies de locatie waarvoor u een bericht wilt indienen.

- Klik op

Create posten kies het typeWhat's New. - Voeg een foto toe, schrijf een kort bericht, selecteer de

Learn moreoptie voorAdd a button (optional), vul je URL in in hetLink for your buttonveld en klik opPublish. - Doe hetzelfde voor pagina’s die linken naar de pagina die u door Google wilt laten indexeren.

8. Automatisch indexeren via de Google Indexing API

Websites die veel pagina’s met een korte levensduur hebben, zoals vacatures, aankondigingen van evenementen of livestreamvideo’s, kunnen de Indexing API (opent in een nieuw tabblad) van Google gebruiken om deze automatisch te vragen nieuwe inhoud en wijzigingen in inhoud te crawlen en te indexeren. Omdat je individuele URL’s kunt pushen, is het een efficiënte manier voor Google om hun index vers te houden.

Met de Indexing API kunt u

- Een URL bijwerken: Google op de hoogte stellen van een nieuwe of bijgewerkte URL om te crawlen

- Een URL verwijderen: Google op de hoogte stellen dat u een verouderde pagina van uw website hebt verwijderd

- De status van een verzoek opvragen: zie wanneer Google de URL voor het laatst heeft gecrawld

Hoewel Google niet aanbeveelt om ze andere contenttypes dan jobs en events te geven, is het me gelukt om gewone pagina’s te indexeren met behulp van de API. Ik heb gemerkt dat de API beter lijkt te werken voor nieuwe pagina’s dan voor herindexering. Google zou dit op een bepaald punt kunnen afdwingen, maar voor nu werkt het prima. RankMath heeft een plugin (opent in een nieuw tabblad) die het werk een stuk makkelijker kan maken, maar vereist wel een beetje setup.

9. Voorzie Google alleen van hoogwaardige content

Het doel van Google is om zo snel mogelijk hoogwaardige content terug te sturen naar zijn gebruikers. Richt u daarom altijd op het leveren van de best mogelijke inhoud aan Google om uw kansen te vergroten om snel te worden geïndexeerd.

Met Google’s strenge inhoudsevaluatie en de eindeloze concurrentie is het creëren en optimaliseren van goede inhoud een proces dat nooit ophoudt.

Naast het genereren van nieuwe inhoud, richt u zich op het verbeteren van wat er al is. Werk slecht presterende content bij, zodat het betere antwoorden oplevert voor potentiële bezoekers. Als u laagwaardige of verouderde inhoud op uw website hebt, kunt u overwegen deze volledig te verwijderen of Google ervan te weerhouden hieraan zijn kostbare crawlbudget te besteden.

Het proces waarbij verouderde, irrelevante of simpelweg te laagwaardige inhoud wordt verwijderd, wordt content snoeien genoemd. Door het dode gewicht te verwijderen, creëer je ruimte voor andere inhoud – die wel potentieel heeft – om te floreren, zodat Google alleen de beste inhoud van je website te zien krijgt.

10. Voorkom duplicate content

Een andere manier om Google’s crawlbudget voor een enorme verspilling te laten zorgen, is het hebben van duplicate content. Deze term verwijst naar zeer vergelijkbare, of identieke, content die op meerdere pagina’s binnen uw eigen website of op andere websites voorkomt.

Over het geheel genomen kan duplicate content echt verwarrend zijn voor Google. In principe indexeert Google slechts één URL voor elke unieke set content. Maar het is moeilijk voor de zoekmachine om te bepalen welke versie moet worden geïndexeerd, en dit wordt vervolgens weerspiegeld in hun zoekresultaten. En als de identieke versies met elkaar blijven concurreren, verlaagt dat de prestaties voor al die versies.

Duplicate content kan een hard probleem worden, vooral voor eCommerce website-eigenaren, die een manier moeten vinden om Google te laten weten welke delen van hun website moeten worden geïndexeerd en welke verborgen moeten blijven.

Daartoe kunt u gebruik maken van robots.txt disallow voor filters en parameters, of u kunt gecanonicaliseerde URL’s implementeren. Maar zoals vermeld in het eerste deel van dit artikel, wees heel voorzichtig met wat u implementeert, want zelfs een kleine verandering kan een negatieve impact hebben.

11. Maak gebruik van interne links en vermijd het gebruik van nofollow

Interne links spelen een grote rol bij het inzichtelijk maken voor Google van de onderwerpen van uw website en de innerlijke hiërarchie. Door strategisch geplaatste interne links te implementeren, maakt u het Google gemakkelijker te begrijpen waar uw content over gaat en hoe het gebruikers helpt.

Zorg ervoor dat u het gebruik van de rel=”nofollow” attribute op uw interne links vermijdt, omdat de nofollow-attribuutwaarde aan Google aangeeft dat het de link niet moet volgen naar de doel-URL. Hierdoor wordt ook geen linkwaarde doorgegeven.

Als je nieuwe pagina’s snel geïndexeerd wilt hebben, moet je strategisch zijn over hoe je intern naar ze linkt.

Het toevoegen van interne links op uw startpagina en site-brede gebieden zoals de header en footer zal het proces van crawlen en indexeren aanzienlijk versnellen.

Overweeg het maken van dynamische gebieden op uw startpagina die uw nieuwste content toont, of dat nu een blogbericht, nieuwsartikel of product is.

U kunt ook links gebruiken binnen een megamenu dat de nieuwste URL’s binnen de verschillende taxonomieën van uw site weergeeft.

12. Bouw relevante backlinks naar je content

Het is geen overdrijving om te zeggen dat linkbuilding een van de belangrijkste disciplines op dit gebied is. De algemene consensus is dat links voor meer dan 50 procent bijdragen aan uw SEO-succes.

Via inkomende links, vaak backlinks genoemd, kan Google uw website ontdekken. En omdat links ook een deel van hun autoriteit overdragen, wordt u sneller geïndexeerd als een backlink afkomstig is van een website met een hoge autoriteit, en het zal uw rankings aanzienlijk beïnvloeden.

Om u te helpen uw indexerings- en rankingmogelijkheden te vergroten, vindt u hier een hele lijst met zeer effectieve linkbuildingstrategieën.

13. Creëer buzz rond je content op sociale media

Eerder in dit artikel hebben we vermeld dat Google veel strenger is geworden als het gaat om welke content ze indexeren. Wanneer u buzz creëert rond uw inhoud op sociale media, signaleert dit aan Google dat de inhoud populair is, wat het indexeringsproces versnelt. Bijvoorbeeld, het posten van uw inhoud op Twitter samen met een paar populaire hashtags kan echt helpen bij het versnellen van het indexeringsproces.

Op de top van dat, zal het creëren van buzz rond uw inhoud ook leiden tot nieuwsbrief inclusies en backlinks!

Omdat Google toegang heeft tot de “firehose data stream” van Twitter (opent in een nieuw tabblad), zul je merken dat alle soorten inhoud – maar vooral nieuwsinhoud – snel ontdekt zal worden als deze op Twitter wordt gedeeld.

Conclusie

Het goed laten indexeren van je website door Google kan een hels karwei blijken te zijn. U moet veel technische, maar ook inhoudelijke en PR-gebaseerde uitdagingen aangaan. En met de recente Google core update in mei 2020 is het indexeren van nieuwe pagina’s nog moeilijker geworden.

Maar met een goede strategie en checklist op zijn plaats, kunt u Google zover krijgen dat het de belangrijkste delen van uw website indexeert en uw SEO-prestaties een boost geeft met hoge rankings.